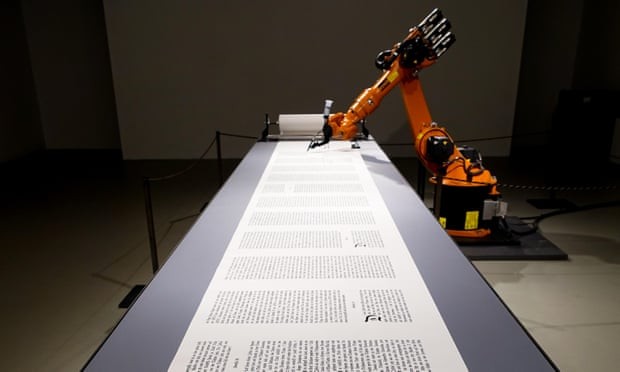

هوش مصنوعی حالا میتواند داستان بنویسد و روزنامهنگاری کند. اما آیا میتواند در حد و اندازههای جورج اورول ظاهر شود یا درباره خروج بریتانیا از اتحادیه اروپا گزارش تهیه کند؟

اوپن ایآی گفت: «با توجه به نگرانیها درباره استفادههای مخرب از این تکنولوژی، مدل آموزشدیده را منتشر نمیکنیم.» آیا این ماشینها به سلاح جدید تروریسم اطلاعاتی تبدیل میشوند یا تنها رماننویسان سطح متوسط را از دور به در میکنند؟

جیپیتی۲ از روشهای تحلیل آماری استفاده میکند که توسط مقادیر عظیمی از متنهای نوشته شده توسط انسان (۴۰ گیگابایت صفحه وب) آموزش دیده است. این رویکرد همان شیوهای است که گوگل ترنسلیت با آن کار میکند.

در حال حاضر به نظر میرسد که داستاننویسان چیز زیادی برای ترسیدن ندارند. وقتی خط اول رمان ۱۹۸۴ جرج اورول را با این مضمون: «یک روز سرد در ماه آوریل بود و ساعتها سیزده را نشان میدادند.» به دستگاه دادند، داستان را اینطور ادامه داد: «در ماشینم در راهِ رفتن به کار جدیدم در سیاتل بودم. بنزین زدم، کلید را چرخاندم و گذاشتم که برود. فقط تصور کردم که امروز چطور خواهد بود. صد سال بعد از این. در ۲۰۴۵ من یک معلم در مدرسهای در بخش فقیر روستایی در چین بودم. با تاریخ چین و علم تاریخ شروع کردم.»

این نوشته به دلایل زیادی گیجکننده است. راوی نمیتواند شغلی در سیاتل داشته باشد و همزمان در مدرسهای در چین کار کند. داستان میبایست در سال ۱۹۴۵ اتفاق افتاده باشد و راوی، آینده شغلی خود را صد سال پس از این با نگاهی نامعقول و خوشبینانه به طول عمر خود، تصور میکند. حتا در سال ۱۹۴۵ او دارد ماشینی را میراند که میتوان از داخل آن را بنزین زد («در ماشینم بودم... بنزین زدم») و ظاهرا نیازی نیست که آن را براند («گذاشتم که برود»).

اطلاعیه سازندگان مبنی بر خطرناک بودن انتشار این برنامه خوب است اما قانعکننده نیست. اوپن ایآی هشدار میدهد که چنین کُدی میتواند برای تولید مقالات خبری گمراهکننده مورد استفاده قرار گیرد، اما در حال حاضر هم به هیچ عنوان کمبود اخبار ساختگی نوشتهشده توسط انسانهای واقعی را احساس نمیکنیم.

نکته اصطلاح «عمیقا جعلی» این است که متونی که این دستگاه تولید میکند از هر متنی که هر انسانی میتواند بنویسد جعلیتر است. با این همه چیزی که بسیار خطرناکتر از اطلاعات نادرست نوشته شده توسط کامپیوتر است، خبرهای جعلی در رسانههای تصویری است که محققان در حال حاضر مشتاقانه روی آنها کار میکنند. وقتی که هر نوع ویدیویی میتواند تولید شود که از شواهد مستند واقعی غیرقابل تشخیص است، ما در دنیایی از مشکلات خواهیم بود.

نظر شما