برخی از این سردرگمیها نشأتگرفته از دو کاربرد بسیار متفاوت از عبارت هوش مصنوعی است. اولی اساسا یک مفهوم بازاریابی است: هر کاری که نرمافزارهای رایانهای انجام میدهند و به نظر هوشمندانه یا بهطور مفیدی پاسخگو میرسد –مثل «Siri»- از هوش مصنوعی استفاده میکند. دومی (که اولی جذبه خود را از آن وام میگیرد) به آیندهای از ماشینهایی با هوش مافوق بشری اشاره دارد که هنوز وجود ندارد و گاهی AGI یعنی هوش مصنوعی عمومی نامیده میشود.

به فرض اینکه بخواهیم، چطور باید از جایی که هستیم، به آن نقطه برسیم؟ هوش مصنوعی مدرن، یادگیری ماشینی (یا یادگیری عمیق) را به کار میگیرد. به این صوورت که بهجای برنامهنویسی مستقیم قوانین برای ماشین، به آن اجازه میدهیم خودش یاد بگیرد. به این ترتیب، «آلفا زیرو» شطرنجبازی که توسط شرکت انگلیسی دیپمایند (که حالا بخشی از گوگل است) خلق شد، میلیونها مسابقه تمرینی با خود انجام داد و بعد موفق به شکست اصلیترین رقیبش شد.

یادگیری ماشینی با آموزش ماشین به کمک مقادیر زیادی داده کار میکند. عکسها برای سیستمهای تشخیص تصویر، یا ترابایتهای یک متن که از اینترنت گرفته شده تا رباتها مقالات تقریبا قابل قبولی تولید کنند، حکم همین دادهها را دارند؛ اما مجموعه دادهها صرفا مخازن خنثایی از اطلاعات نیستند. آنها اغلب سوگیریهای انسانی را بهروشهای پیشبینینشده رمزگذاری میکنند. در چندین ایالت امریکا این هوش مصنوعی برای پیشبینی اینکه آیا نامزدهای عفو مشروط مجددا مرتکب جرم خواهند شد، در حال استفاده است و منتقدان ادعا میکنند دادههایی که الگوریتمها روی آنها آموزش میبینند، نشاندهنده سوگیری تاریخی توسط نیروی پلیس است.

اخیرا شاهد بودیم که ربات «آی-دا» با استفاده از بانک اطلاعاتی واژهها و تحلیل الگوهای گفتاری توانست اثری در واکنش به کمدی الهی دانته خلق کند و قرار است روز جمعه شعرهای خود را در موزه اشمولین آکسفورد بخواند. با اینکه آی-دا اولین هوش مصنوعی نیست که شعر گفتن را آموخت، اما نخستین رباتی خواهد بود که شعری را که با الگوریتمهای هوش مصنوعی خود نوشته است، برای عموم میخواند. آیدن ملر، متخصص هنر و سازنده این ربات میگوید با آنکه شعر آی-دا را قابل مقایسه با شاعران انسانی نمیبیند اما اعتراف میکند که این اتفاق اساسا نگرانکننده است. او امیدوار است که هنرمندان، شاعران، نویسندگان و غیره بهطور فزایندهای با فناوریهای جدید نظیر هوش مصنوعی درگیر شده و از آنها استفاده کنند، زیرا یکی از بهترین راهها برای نقد، ارزیابی و برجسته کردن مشکلات احتمالی، استفاده واقعی و تعامل با این فناوریهاست. به عقیده او «مساله رقابت نیست، بلکه بحث و اقدام بالقوه است. همه ما باید نگران استفاده گسترده از مدلهای زبان هوش مصنوعی در اینترنت باشیم و اینکه چگونه در آینده بر زبان و مهمتر از آن، ساخت معنا تاثیر میگذارند. اگر برنامههای کامپیوتری بیشتر از انسانها محتوایی خلق کنند که روح و جامعه انسان را تحت تاثیر قرار دهد، در این صورت شاهد جابهجایی و تغییر حیاتی در استفاده و تاثیر زبان خواهیم بود –که باید دربارهاش بحث و فکر شود.»

.jpg)

مشکل وجودی این است که اگر رایانهها در نهایت به نوعی هوش خودآگاه خداگونه دست پیدا کنند، آیا همچنان مشتاق خدمترسانی خواهند بود؟ اگر چیزی چنین قدرتمند میسازیم، بهتر است از این مطمئن شویم که به خودمان پشت نمیکند. برای کسانی که بهطور جدی نگران این موضوع هستند، این بحث چنین ادامه پیدا میکند که از آنجایی که این یک مشکل بالقوه است، باید اکنون منابع را برای مبارزه با آن اختصاص دهیم. نیک بوستروم، فیلسوفی که ریاست موسسه «آینده بشریت» دانشگاه آکسفورد را بر عهده دارد میگوید انسانهایی که سعی در ساخت هوش مصنوعی دارند، مانند کودکانی هستند که با بمب بازی میکنند و دورنمای ادراک ماشینی تهدیدی بزرگتر از گرمایش جهانی برای انسان محسوب میشود. کتاب «فراهوش» او بسیار اثرگذار است. او در این کتاب به این مضوضوع اشاره میکند که یک هوش مصنوعی واقعی ممکن است مخفیانه گازهای عصبی یا نانورباتهایی بسازد تا سازندگان زیردست و ساختهشده از گوشت و خون خود را نابود کند. یا ممکن است ما را در یک باغ وحش سیارهای نگه دارد، در حالی که به کار واقعیاش ادامه میدهد.

برای آنکه فاجعه رخ دهد نیازی نیست که هوش مصنوعی بهطور فعال مخرب باشد. این موضوع با نظریه معروف بوستروم، «مشکل گیره کاغذ» نشان داده شده است. فرض کنید به یک هوش مصنوعی میگویید گیره کاغذ بسازد و فراموش میکنید به آن بگویید چه وقت ساخت این گیرهها را متوقف کند. دکمه خاموش را هم در ابتدای کار غیرفعال کردهاید، زیرا اگر اجازه خاموش کردن خود را داشته باشد، ممکن است هدف اصلیاش را که ساختن گیره کاغذ است دنبال نکند و در نهایت این هوش مصنوعی تمام مواد روی زمین را به گیره کاغذ تبدیل خواهد کرد.

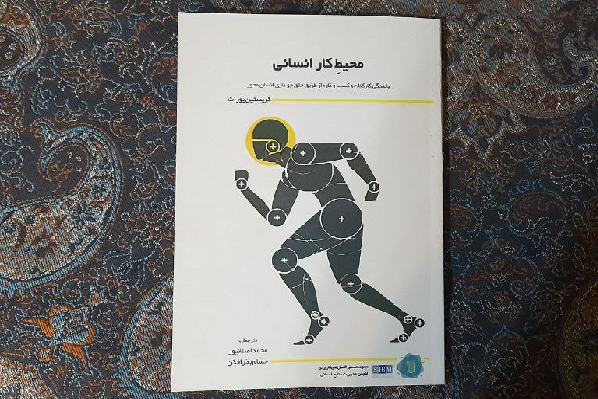

این نمونهای از «مساله کنترل» کلی است؛ موضوع کتاب فوقالعاده استوارت راسل، از پیشگامان هوش مصنوعی با عنوان «سازگار با بشر: هوش مصنوعی و مساله کنترل» که استدلال میکند تعیین هرگونه هدف برای یک ماشین فراهوشند به منظور جلوگیری از چنین سوءتفاهمهای فاجعهباری غیرممکن است. در همین حال، مکس تگمارک، فیزیکدان و از بنیانگذاران موسسه «آینده زندگی» در کتاب «زندگی ۳: انسان بودن در عصر هوش مصنوعی» بر مساله «همسویی ارزشها» تاکید دارد، اینکه چطور اطمینان حاصل کنیم که ارزشهای ماشین با ارزشهای ما مطابقت دارد. با در نظر گرفتن این نکته که هزاران سال فلسفه اخلاق هنوز برای توافق بشر بر سر این موضوع که ارزشهای ما واقعا چه هستند کافی نبوده، این هم میتواند مشکلی حلنشدنی باشد.

با این حال ناظران دیگر آرام و خونسرد هستند. جیمز لاولاک، دانشمند تکرو و نظریه پرداز «فرضیه گایا» استدلال میکند که انسانها باید خوشحال شوند اگر بتوانیم ماشینهای هوشمند را به مرحله منطقی بعدی تکامل راهنمایی کرده، سر تعظیم فرود آوریم و خود را منسوخ قلمداد کنیم. جینت وینترسون در اثر اخیر خود، «۱۲ بایت» بسیار خوشبین است که هوشهای مصنوعی آینده حداقل راغب به طمع، زمینخواری، موقعیتطلبی و خشونتی که مشخصه انسان خردمند است، نخواهند بود. همانطور که درو مکدرموت، دانشمند کامپیوتر در مقالهای که در سال ۱۹۷۶ منتشر کرد اشاره کرد که شاید در نهایت باید از هوش مصنوعی کمتر از حماقت طبیعی بترسیم.

نظر شما